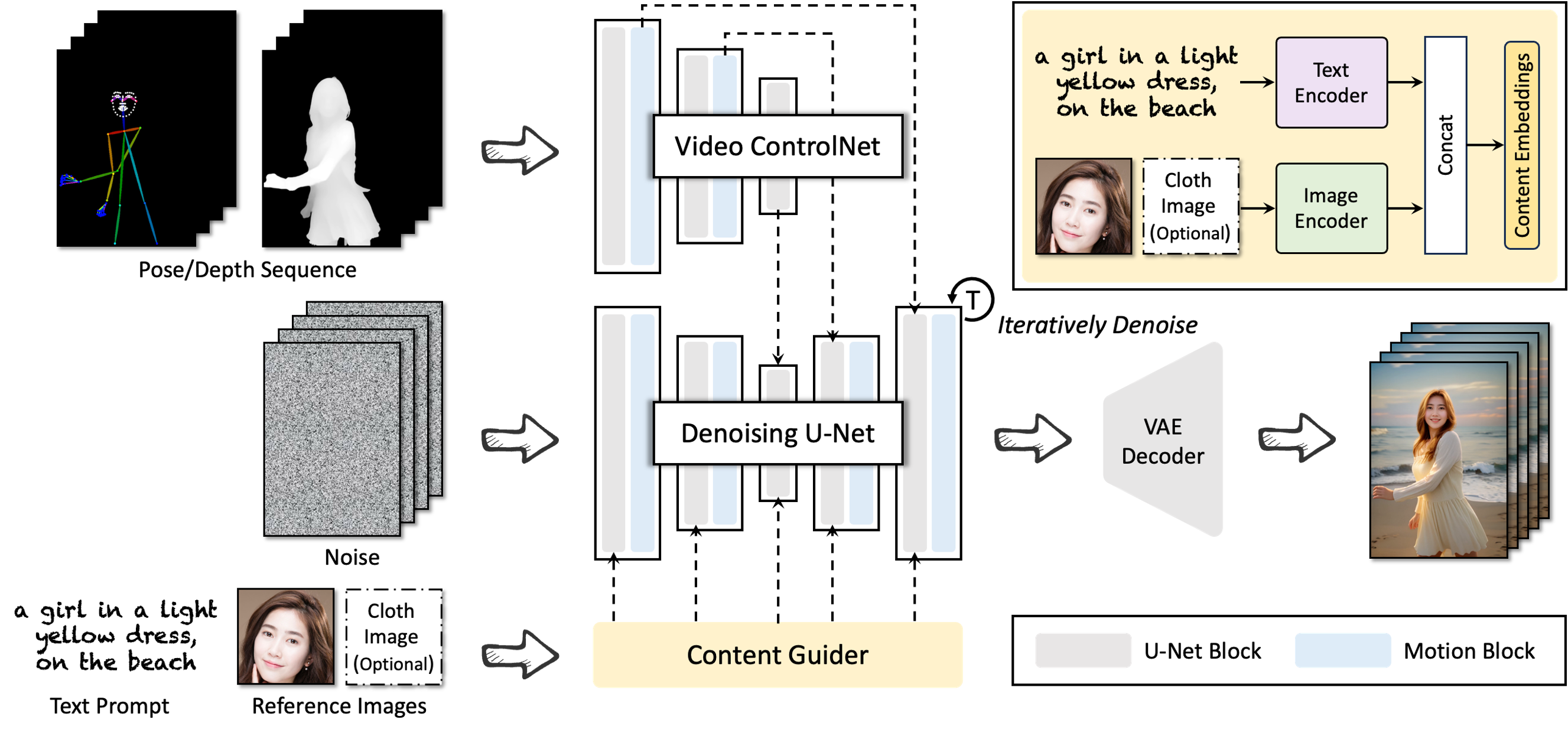

DreaMoving是一个基于扩散模型的可控视频生成框架,用于生成高质量的定制人类舞蹈视频。它由两个主要组件组成:视频控制网络和内容导引器。

视频控制神经网络用于控制生成视频的运动。它将输入的姿势序列作为附加的时间残差输入到扩散模型中。使模型能够学习和生成与参考姿势序列一致的运动视频。

内容导引器用于保留生成视频的身份信息。它将输入的目标身份参考图像作为输入,并将其转换为内容嵌入。这些内容嵌入然后与扩散模型的输出交叉注意,以帮助模型保持生成视频与目标身份的一致性。

DreaMoving可以生成高质量和高保真度的视频,给定指导序列和简单的内容描述,例如文本和参考图像作为输入。具体来说,DreaMoving通过人脸参考图像、通过姿势序列进行精确运动操作以及由指定文本提示提示的全面视频外观控制来展示身份控制的熟练程度。

以下是 DreaMoving 生成的一些示例视频:

DreaMoving 具有广泛的潜在应用,包括:

- 影视制作中的角色替换

- 虚拟时尚展示

- 个性化视频内容创作

- 教育和培训

- 虚拟现实和游戏

- 艺术创作和展览

DreaMoving 是一个强大的工具,可用于生成各种高质量的定制视频。它有可能在许多不同领域产生影响。

DreaMoving可以生成高质量和高保真度的视频,给定指导序列和简单的内容描述,例如文本和参考图像作为输入。

具体来说,DreaMoving通过人脸参考图像、通过姿势序列进行精确运动操作,以及由指定文本提示词引导生成具体的场景,实现针对人物身份的控制。

官方网址:github.com/dreamoving/dreamoving-project

前往官网

声明:本文来自AIGC收录导航网投稿,不代表吾站网立场,版权归原作者所有,欢迎分享本文,转载请保留出处!